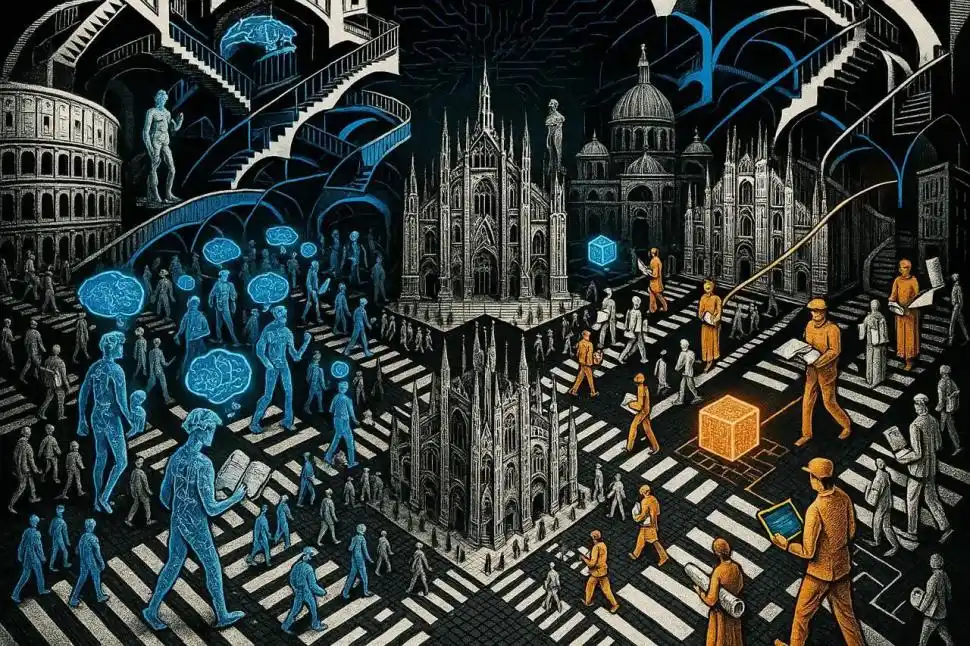

Un avance según esta línea de pensamientos React: Synergizing Reasoning and Acting in Language Models y en el campo de los desarrollo de asistentes de Inteligencia Artificial (IA) promete sistemas más confiables y menos propensos a “inventar” información, al forzarlos a pensar y buscar datos en tiempo real.

La inteligencia humana se basa en la capacidad de coordinar el pensamiento verbal (esa “voz interior” que usamos para planificar o autorregularnos) con acciones concretas. Por ejemplo, mientras realizamos una tarea compleja, nuestra mente descompone metas, rastrea el progreso o ajusta el plan si algo sale mal.

Los grandes modelos de lenguaje (LLMs, la tecnología detrás de los chatbots avanzados) están adoptando ahora esta estrategia a través de un nuevo paradigma llamado ReAct (acrónimo de Reasoning and Acting, Razonamiento y Actuación).

ReAct permite a la IA generar rastros de “razonamiento” (“pensamiento”) y acciones específicas de forma intercalada. Esta combinación es esencial: el “razonamiento” guía la planificación y el ajuste de alto nivel, mientras que la acción permite a la IA interactuar con fuentes externas, como una API similar a Wikipedia (ver Co-Storm Get a Wikipedia-like report on your topic with AI) , para incorporar nueva información.

El mecanismo

ReAct amplía lo que la IA puede hacer al agregar un espacio para el lenguaje interno (el “pensamiento”) que no afecta directamente el entorno, pero sí la estrategia de la máquina.

“El razonamiento” (“pensamiento”): genera el “paso a paso” lógico. Su objetivo es ayudar al modelo a descomponer metas, planificar acciones o manejar excepciones. El razonamiento es dinámico y se ajusta continuamente.

La actuación (acción): son los pasos concretos realizados en el mundo exterior, como buscar una entidad en una base de conocimientos. Esto permite a la IA recopilar hechos y actualizar su conocimiento en tiempo real.

El impacto directo en la vida diaria

La capacidad de pensar y actuar de forma sinérgica hace que los sistemas impulsados por ReAct sean significativamente más robustos, transparentes y confiables.

Respuestas basadas en hechos y menos “alucinaciones”: uno de los principales problemas de los modelos de IA que solo “piensan” internamente (como el Chain-of-Thought o COT) es la tendencia a las alucinaciones de hechos o la propagación de errores en su razonamiento. Los modelos de “razonamiento” interno no están anclados al mundo externo.

ReAct combate esta debilidad al forzar a la IA a fundamentar sus respuestas interactuando con fuentes de conocimiento externas, como una API de Wikipedia.

El proceso de resolución de problemas con ReAct es más impulsado por hechos (fact-driven) y confiable. ReAct reduce significativamente el riesgo de inventar información: en los modos de éxito, la tasa de falsos positivos (razonamiento incorrecto o alucinado) del método COT era del 14%, mientras que ReAct la reduce al 6% gracias a su acceso a bases de conocimiento externas.

Esta capacidad de interactuar con la web permite a ReAct proporcionar respuestas actualizadas. Por ejemplo, mientras otros métodos pueden alucinar o usar datos desactualizados sobre el tamaño de un hotel, ReAct es capaz de buscar la información más reciente y precisa.

Decisiones más robustas

ReAct es altamente efectivo en tareas interactivas que exigen planificación a largo plazo y exploración sistemática.

Asistencia en línea y compras: en simulaciones de compra en línea (WebShop), ReAct usa el “razonamiento” para decidir qué opciones de productos son relevantes para las instrucciones del usuario, lo que resulta en una mejora optiizada en las tasas de éxito sobre métodos anteriores.

Planificación de tareas: en juegos de texto complejos (ALFWorld), donde las tareas requieren muchos pasos, ReAct superó a métodos basados en aprendizaje por imitación y refuerzo por una tasa de éxito en su eficiencia. La clave es que el razonamiento evita que el modelo pierda el hilo de las submetas o se quede atascado en bucles.

Colaboración humana

Para el usuario final, ReAct mejora la interpretabilidad, la confiabilidad y la capacidad de diagnóstico del modelo.

Diagnóstico: al poder ver los rastros de “pensamiento” generados por la IA, los humanos pueden examinar el razonamiento y verificar la corrección fáctica de las decisiones tomadas.

Control en tiempo real: ReAct facilita una nueva forma de colaboración entre humanos y máquinas. Si la IA comete un error en su “razonamiento” interno (un “pensamiento” erróneo), un humano puede intervenir y editar ese rastro de pensamiento para cambiar drásticamente el comportamiento de la IA y guiarla hacia el éxito. Esto convierte una tarea compleja en algo más simple, pasando de teclear muchas acciones a solo editar un par de “pensamientos”.

Mientras que Neuralink, de Elon Musk, probará implantes para convertir los pensamientos en texto y si pensamos que proporciona el hardware y la velocidad neuronal para la “descarga mental” instantánea, ReAct es la arquitectura de software que garantiza que el procesamiento de esa consulta sea transparente, lógicamente sólido y, crucialmente, anclado a la verdad, asegurando que la IA no responda a la velocidad del pensamiento con una invención de alta velocidad, será ficción o realidad?