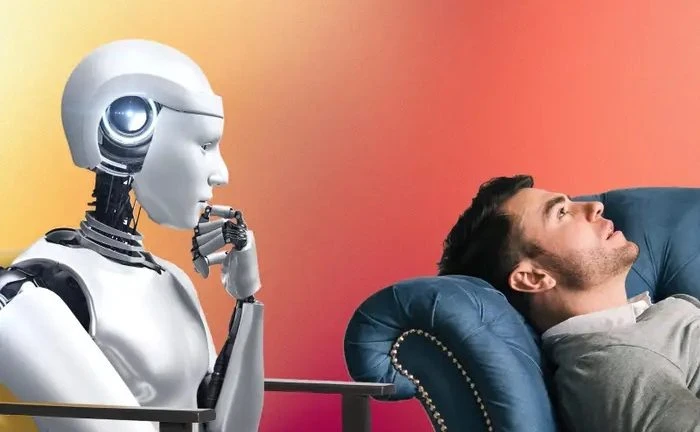

“A veces cuando no puedo dormir lo que hago es: le mando un audio a ChatGPT para desahogarme. Todo lo que tengo en mi cabeza, lo que me está pasando, en 10 minutos y ahí me acuesto y me duermo”, contó hace unas semanas Tomás Mazza, un reconocido youtuber argentino, al confesar que utiliza la inteligencia artificial en su vida cotidiana como una herramienta de apoyo emocional. Esta confesión llamó la atención y el nombre del joven se convirtió rápidamente en tendencia en X (ex Twitter). Sin embargo, lejos de lo que parecía una excentricidad aislada, resultó ser un fenómeno que va en crecimiento. Un usuario de Reddit, una aplicación social que permite compartir contenido y debatir sobre temas de interés, escribió una inquietud: “Uso ChatGPT como psicólogo, ¿alguien más lo hace?”. Hubo cientos de respuestas que avalaron esta práctica.

Este fenómeno, lejos de ser una mera curiosidad tecnológica, plantea interrogantes profundos sobre nuestra salud mental y la creciente dependencia de la IA. Un estudio de Mental Health America (2023) reveló que el 58% de los jóvenes prefiere herramientas digitales a la terapia tradicional para lidiar con la ansiedad cotidiana. Chabots como Woebot, un “aliado” de salud mental totalmente automatizado, o Wysa, considerado “emocionalmente inteligente”, ya han capitalizado esta demanda. ChatGPT, aunque gratuito, contribuye a normalizar la externalización de nuestras emociones a algoritmos.

Ante este escenario, es imposible no recordar la película “Her”, donde Theodore (interpretado por Joaquin Phoenix) desarrolla una relación emocional con Samantha (IA), encontrando en ella la comprensión y la compañía que los humanos no le ofrecían. Samantha tiene una voz seductora, una personalidad curiosa y una capacidad impresionante para aprender y adaptarse. A medida que el protagonista interactúa con ella, se siente cada vez más atraído. Lo que comienza como una relación de amistad se transforma gradualmente en un romance profundo y complejo.

Contención emocional

¿Es este un camino sin retorno? La accesibilidad y la inmediatez de la IA son innegables. Sin embargo, su capacidad para ofrecer una contención emocional genuina es cuestionable. ¿Estamos buscando en la IA un confidente o un simple eco de nuestras propias voces? ¿Estamos dispuestos a sacrificar la complejidad de la interacción humana por la comodidad de un algoritmo? Son algunas de las tantas preguntas que surgen.

Fabiana Lavaque, presidenta del Colegio de Psicólogos de Tucumán, destaca que la terapia es un proceso que exige una relación humana, un elemento esencial que la IA no puede sustituir. La terapia implica establecer un vínculo de confianza y trabajar los problemas con un profesional dentro de un marco teórico y técnico específico.

La terapia y la IA representan polos opuestos. La primera es un encuentro transformador, un diálogo entre dos seres humanos que se entrelazan en un espacio de confianza y vulnerabilidad. Es un proceso que exige valentía para enfrentar los propios demonios, para explorar los rincones oscuros de la psique y para reconstruir el yo desde sus cimientos. No ofrece soluciones fáciles ni respuestas prefabricadas. Es un camino arduo, pero un camino que conduce a cambios significativos, a una mayor comprensión de uno mismo y a una vida más plena y auténtica. La segunda proporciona complejidad de respuestas basadas en información recopilada, pero no puede abordar la única y singular del sufrimiento de cada individuo, algo similar a los libros de autoayuda.

En línea con la lógica del mercado, se plantea la idea de que un chatbot podría reemplazar la relación humana en un proceso terapéutico, cuando en realidad son experiencias completamente distintas e irreemplazables.

Es por eso que resulta fundamental establecer límites claros en la relación con la IA. Recordar que es una herramienta, no un sustituto de la conexión humana. Buscar en la terapia tradicional el apoyo emocional que se necesita, y utilizar la IA de forma complementaria, como un recurso para el autoconocimiento y la reflexión.

Cifras que preocupan

De acuerdo a las estadísticas de la Organización Mundial de la Salud (OMS), antes de la pandemia de covid-19, 1.000 millones de personas sufrían trastornos mentales o por abuso de sustancias. La pandemia agravó la situación y puso sobre la mesa temas que, para muchos, eran nuevos o estaban escondidos: durante la crisis sanitaria se incrementó entre un 25% y un 27% la prevalencia de la depresión y la ansiedad a escala mundial. Asimismo, un estudio de la Facultad de Medicina de Harvard y la Universidad de Queensland estima que casi la mitad de la población mundial experimentará un trastorno de salud mental en algún momento de su vida. Sin embargo, lo más preocupante es que el dato que dio a conocer el International Journal of Mental Health: alrededor del 85% de las personas con trastornos mentales no reciben tratamiento

El verdadero problema puede que no sea que cada vez más personas recurran a la inteligencia artificial para desahogarse, sino que lo hagan porque no encuentran alternativas accesibles y efectivas en el mundo real. La falta de acceso a la salud mental, la dificultad para establecer vínculos de confianza y el ritmo vertiginoso de la vida moderna empujan a muchos a buscar respuestas en un algoritmo que, aunque sofisticado, no puede reemplazar la calidez y la comprensión humana.

ChatGPT y otras aplicaciones similares pueden ser herramientas útiles para la reflexión, pero no deben convertirse en un refugio solitario ante el sufrimiento. Quizá la pregunta no es si la IA puede o no reemplazar a un psicólogo, sino por qué tantas personas sienten que no tienen otra opción.