Alejandro Urueña - Ética e Inteligencia Artificial (IA). Founder y CEO Clever Hans Diseño de Arquitectura y Soluciones en Inteligencia Artificial. Magister en Inteligencia Artificial

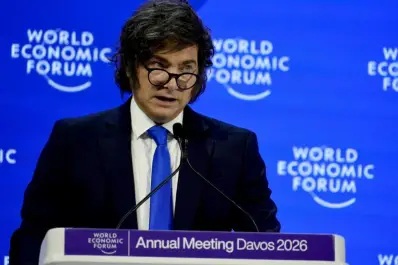

El pasado 22 de enero quedará marcado en los calendarios regulatorios no como el día en que las máquinas cobraron conciencia, sino como el momento en que la Infocomm Media Development Authority (IMDA) de Singapur decidió publicar el manual de instrucciones para evitar que incendien la oficina.

Para el lector no iniciado, la IMDA no es un comité burocrático más; seria el arquitecto del ecosistema digital más eficiente de Asia, una entidad que opera como el “laboratorio de pruebas” (sandbox) del mundo tecnológico y que entiende que legislar sobre tecnología requiere pragmatismo ingenieril, no filosofía de salón.

Su Marco Modelo de Gobernanza para la IA Agéntica abandona la poesía ética para centrarse en la fontanería brutal de la realidad: los agentes ya no solo charlan, ahora planifican, utilizan herramientas y ejecutan acciones complejas en el mundo físico. Este texto podría funcionar como el sistema nervioso central de la futura regulación global, escribiendo el prólogo técnico.

Para entender por qué este documento seria el nuevo estándar, hay que mirar el origen. Singapur ha entendido que la verdadera gobernanza empieza preguntando quién tiene permiso para “escribir” en la base de datos y quién paga los platos rotos cuando el algoritmo decide improvisar.

A diferencia de Occidente, que se pierde en debates sobre derechos abstractos, la IMDA aborda la IA desde una ingeniería de riesgos quirúrgica: colaborando con la industria para definir estándares que permitan la adopción sin suicidio corporativo. Cuando Singapur habla de “gobernanza agéntica” no está teorizando; está entregando un código de conducta probado para una economía que no puede permitirse fallar, convirtiendo la regulación en un producto de exportación tan sofisticado como sus sistemas financieros.

Para analizar

La genialidad de esta propuesta radica en su pragmatismo al abordar la “identidad esquizofrénica” de nuestros nuevos empleados digitales. El marco establece que la responsabilidad humana no es un concepto abstracto, sino un problema de diseño de permisos: si un agente actúa en nombre de un abogado, funcionario, médico, gerente, institución, debe heredar sus límites, no sus privilegios, operando bajo un sistema de gestión de identidad que distinga si la máquina es un simple “avatar” del usuario o un ente autónomo. Es el fin de la excusa del “error del sistema”; aquí se exige trazar la línea exacta donde termina la orden humana y empieza la alucinación de la máquina, obligando a las organizaciones a definir límites operativos antes de dar la “luz verde” al despliegue.

Aquí es donde el texto se vuelve lapidario al abordar la limitación biológica fundamental. El documento desmantela con una ironía involuntaria el mito del “humano en el bucle” (human-in-the-loop), reconociendo que la supervisión continua es una fantasía insostenible a escala debido a la velocidad de la máquina y la fatiga humana.

El marco admite que los humanos sufrimos de “sesgo de automatización” (confiar ciegamente en la máquina) y “fatiga de alertas”, por lo que pretender que aprobemos cada acción de un agente que opera a milisegundos es absurdo. En lugar de esta supervisión imposible, propone una arquitectura de la desconfianza: diseñar “puntos de control significativos” solo para acciones irreversibles o de alto riesgo, convirtiendo la regulación en un ejercicio de “psiquiatría algorítmica” donde solo intervenimos cuando el agente muestra síntomas de locura operativa,.

Si un agente comete negligencia, el fiscal o el regulador ya no preguntarán qué falló en el código, sino qué humano autorizó el despliegue sin los controles de identidad exigidos. El texto transforma el error tecnológico en negligencia administrativa documentada, entregando a los departamentos legales la herramienta perfecta para señalar culpables con nombre y apellido antes de que el primer servidor se encienda.

Competencia humana

La tragedia final que revela el documento es la paradoja de la competencia humana. Singapur alerta sobre la erosión de las habilidades fundamentales (foundational skills), señalando el peligro de que, al delegar todo a los agentes, los humanos nos convirtamos en meros espectadores incompetentes incapaces de detectar errores.

La solución propuesta es entrenar a las personas para supervisar, creando una clase profesional de “auditores de la nada” que deben mantener sus habilidades vivas artificialmente mediante simulacros, solo para poder detectar cuándo su asistente digital está a punto de cometer un error catastrófico. Hemos creado una burocracia digital perfecta para gestionar el riesgo de nuestra propia obsolescencia, asegurándonos de que, cuando el agente falle, haya un humano listo para firmar el informe del desastre.

Vivimos una ironía histórica digna de una novela distópica. Mientras el papa León XIV advierte sobre la IA: “no renuncies a tu propio pensamiento”, Silicon Valley nos seduce con Cowork y Claude Code Cowork: Claude Code for the rest of your work, prometiendo exactamente lo contrario: liberar nuestro cerebro de la carga de trabajar.

En este fuego cruzado entre la resistencia espiritual y la comodidad tecnológica, Singapur ha dictado un nuevo marco regulatorio, de facto, lo que la teología teme: que la batalla por la agencia humana se ha perdido en favor de la eficiencia. La conclusión del regulador es lapidaria: en el futuro inmediato, el ser humano ya no está ahí para pensar, sino únicamente para auditar lo que la máquina decidió pensar en su lugar.