Por Alejandro Urueña- Ética e Inteligencia Artificial (IA) - Founder & CEO Clever Hans Diseño de Arquitectura y Soluciones en Inteligencia Artificial. Magister en Inteligencia Artificial.

Y María S. Taboada - Lingüista y Mg. en Psicología Social. Prof. de Lingüística General I y Política y Planificación Lingüísticas de la Fac. de Filosofía y Letras de la UNT.

En un panorama digital donde la línea entre lo público y lo privado se desdibuja constantemente, dos casos distintos, pero intrínsecamente conectados, ponen de manifiesto la vulnerabilidad de la información personal. Por un lado, una condena millonaria para un gigante tecnológico por rastreo intrusivo de sus propios usuarios, y por otro, una profunda investigación sobre la extracción masiva de datos de internet para el entrenamiento de sistemas de inteligencia artificial (IA). Ambos escenarios, si bien difieren en sus métodos de recolección y las instancias específicas de su ocurrencia, convergen en una preocupación fundamental: el valor en resguardo es, y siempre ha sido, la privacidad individual. La paradoja se hace patente cuando las empresas argumentan la "disponibilidad pública" de los datos como una exención legal, mientras que la realidad muestra una explotación a gran escala que ignora las expectativas y derechos de los usuarios.

Rastreo persistente

El primer caso concierne a Google, Rodríguez v. Google LLC (3:20-cv-04688) que inicialmente se enfrentaba a una demanda en la que los usuarios buscaban más de 31.000 millones de dólares en daños y perjuicios por invasión de la privacidad. La demanda colectiva, presentada en julio de 2020, acusaba a Google de continuar recopilando datos de millones de usuarios durante un período de ocho años, a pesar de que estos habían desactivado explícitamente la función de seguimiento en su configuración de Actividad Web y de Aplicaciones. Esta recolección se habría realizado al acceder a dispositivos móviles y utilizar datos a través de su relación con aplicaciones populares como Uber, Venmo e Instagram. A pesar de la negación de Google, que argumentaba que los datos eran "no personales, seudónimos y almacenados en ubicaciones segregadas, seguras y encriptadas", un jurado federal en San Francisco determinó finalmente que la compañía debe pagar 425 millones de dólares. El jurado encontró a Google responsable de dos de las tres reclamaciones de violaciones de privacidad, aunque dictaminó que no había actuado con malicia, lo que impidió la otorgación de indemnizaciones punitivas. Google ha anunciado su intención de apelar el veredicto, alegando una "mala interpretación" de cómo funcionan sus productos. Esta sentencia, que abarcó a aproximadamente 98 millones de usuarios y 174 millones de dispositivos, destaca la batalla legal contra el rastreo persistente y no consentido de la información personal en línea.

Datos personales

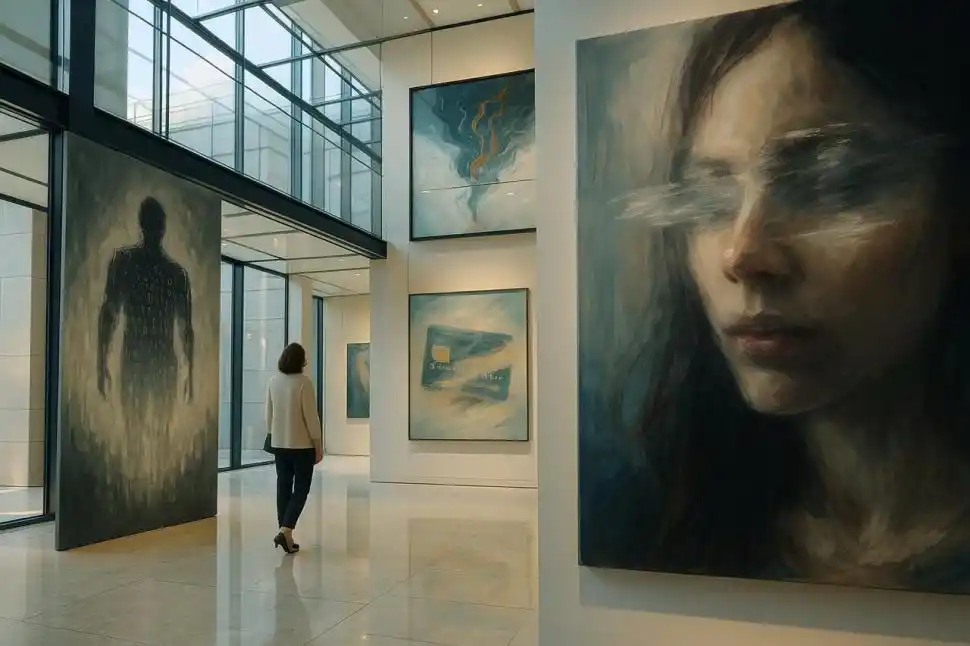

Por otra parte, una investigación A Common Pool of Privacy Problems: Legal and Technical Lessons from a Large-Scale Web-Scraped Machine Learning Dataset exhaustiva sobre los grandes conjuntos de datos de internet, como DataComp CommonPool, expone una problemática igualmente grave, aunque con una metodología de recolección diferente: el web scraping a gran escala e indiscriminado para entrenar sistemas de IA. A pesar de los esfuerzos por anonimizar la información, el estudio encontró una "significativa presencia" de Información Personal Identificable (PII). Se hallaron ejemplos concretos como números de tarjetas de crédito, de pasaporte, licencias de conducir, certificados de nacimiento y currículums (se estima en al menos 142.000 imágenes de currículums de individuos con presencia pública en línea). Aún más, se identificaron datos sociodemográficos vinculados a nombres y aproximadamente 102 millones de imágenes de rostros humanos reales que permanecieron sin ser difuminados, a pesar de los mecanismos de ofuscación implementados por defecto. La investigación objeta la premisa de que la información "públicamente disponible" en internet está exenta de las leyes de privacidad, argumentando que esta visión simplista ignora el contexto original de la divulgación y las expectativas razonables de privacidad de los individuos. Esta práctica masiva de recopilación contraviene principios fundamentales de protección de datos como la minimización y la limitación del propósito. El estudio sugiere que una regulación más efectiva debería enfocarse en la fuente de los datos ("la raíz") en lugar de abordar los problemas en cada modelo de IA individualmente ("las hojas"), para mitigar los riesgos de privacidad a gran escala. Esto es crucial, ya que, aunque DataComp CommonPool fue diseñado para investigación, su licencia CC-BY-4.0 no prohíbe el uso comercial de los modelos entrenados con estos datos, y su precursor, LAION-5B, ya se ha utilizado para entrenar modelos como Midjourney y Stable Diffusion.

Desafíos legales y éticos

En última instancia, ya sea por el "rastreo silencioso" de una corporación o por la "cosecha indiscriminada" de datos para alimentar la inteligencia artificial en cualquiera de sus etapas de desarrollo, el valor fundamental de la privacidad sigue siendo el pilar central de los desafíos legales y éticos. La sentencia contra Google y las revelaciones sobre DataComp CommonPool subrayan la necesidad de marcos legales más robustos que se enfoquen en la fuente y el propósito de los datos, en lugar de intentar mitigar los problemas a posteriori. Este enfoque busca asegurar que la tecnología y sus desarrollos respeten las expectativas de privacidad de las personas en un mundo cada vez más interconectado.