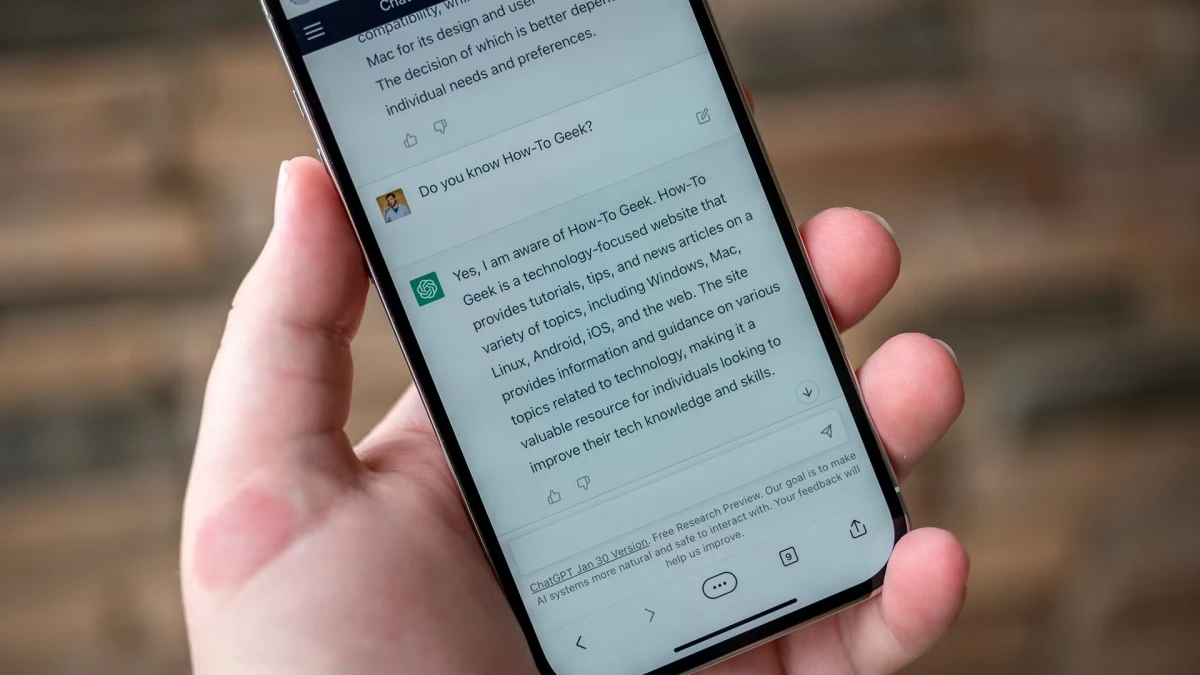

TECNOLOGÍA. Un intercambio cortés con ChatGPT activa procesos computacionales que consumen electricidad y agua, lo que ya generó millones en costos para OpenAI. / FREEPIK

TECNOLOGÍA. Un intercambio cortés con ChatGPT activa procesos computacionales que consumen electricidad y agua, lo que ya generó millones en costos para OpenAI. / FREEPIK

El uso cotidiano de herramientas de inteligencia artificial como ChatGPT está transformando la forma en la que las personas interactúan con la tecnología. Lo que parecía una simple muestra de buena educación, escribir “por favor” o “gracias”, se convirtió en el centro de un debate inesperado: ¿cuánto cuesta la cortesía digital?

Recientemente, un usuario de la red social X le preguntó al CEO de OpenAI, Sam Altman, cuánto dinero pierde la empresa por responder amablemente a estos gestos humanos. La respuesta fue tan breve como reveladora: “decenas de millones de dólares bien gastados. Nunca se sabe”.

Un gesto amable que consume recursos

Los modelos de lenguaje como ChatGPT están diseñados para responder a todo. Incluso a las frases corteses que muchos usuarios incluyen por hábito o afecto. Lo que no se sabía hasta ahora es que esas pequeñas interacciones generan procesos computacionales innecesarios que implican un alto consumo energético.

Cada vez que alguien escribe un “gracias” o un “por favor”, el sistema debe procesar la frase, analizar su contexto y generar una respuesta adecuada. Aunque parezca una tarea sencilla, se trata de un esfuerzo computacional que requiere de electricidad y no poca. Esto sucede porque los servidores que alojan y ejecutan a ChatGPT, ubicados en centros de datos a gran escala, necesitan energía tanto para funcionar como para refrigerarse.

Además del costo eléctrico, también está el impacto ambiental: según investigaciones recientes, los grandes modelos de lenguaje consumen una enorme cantidad de agua para evitar el sobrecalentamiento de sus sistemas. Esto ocurre porque los centros de datos utilizan agua para enfriar los servidores, sobre todo en regiones donde se usan sistemas de refrigeración líquida. Por lo tanto, una respuesta innecesaria de IA no sólo implica un gasto energético, sino también de un recurso cada vez más escaso: el agua potable.

¿Qué implica esto para el futuro del uso de IA?

Este tipo de hallazgos pone sobre la mesa una nueva discusión sobre cómo usamos la inteligencia artificial en el día a día. Si bien la cordialidad parece un gesto inocente, cuando millones de personas lo replican, el impacto es significativo. De hecho, especialistas advierten que deberíamos empezar a pensar en el uso responsable del lenguaje con las máquinas, especialmente si se busca escalar el acceso global a estas tecnologías.

Por otra parte también hay un desafío cultural: muchas personas sienten que hablar de forma “humana” con ChatGPT mejora su experiencia y les permite sentirse más cómodas usando la herramienta. Es parte del efecto “antropomórfico” que producen los modelos conversacionales. Sin embargo, esta forma de relacionarnos con la IA puede tener consecuencias concretas que no se habían previsto. Sí conviene recordar que un "por favor" y un "gracias" no cuestan nada entre personas.