Pwqartificial

Pwqartificial

Seas del país que seas, ciudadano por opción o no, si no eres de la Unión Europea, el futuro de los derechos fundamentales y migratorios tiene distinciones en el contexto de la tecnología de vigilancia y la migración presenta un panorama de desconfianza. La Ley de Inteligencia Artificial (IA) de la Unión Europea, aunque nos ilusiona, no estará en vigencia hasta 2026 aproximadamente. Durante este plazo, se anticipa que el desarrollo y la implementación de sistemas de IA potencialmente perjudiciales continuarán sin limitaciones en diversos sectores públicos con las consecuencias e injusticias que esto podría traer.

Esta legislación forma solo una parte de un marco legal más amplio en la UE que facilita el uso de tecnologías de vigilancia. El Parlamento Europeo implementó la nueva Ley de Inteligencia Artificial de la Unión Europea el 13 de marzo de 2024, una luz considerada por muchos y como un avance esperanzador. Sin embargo, esta regulación presentaría claras deficiencias en lo que respecta al hecho de cuestiones migratorias, con déficit en su deber de evitar perjuicios, prejuicios y asegurar salvaguardas para aquellos que se encuentran en tránsito.

La versión final de esta ley establece un precedente preocupante. Crea un marco normativo específico o paralelo para la aplicación de la inteligencia artificial por entidades de orden público, gestión de fronteras y seguridad nacional. Además, introduce excepciones legales que no encuentran justificación adecuada y promueve el empleo de tecnologías propensas a facilitar la vigilancia selectiva y discriminatoria contra sectores vulnerabilizados de la población.

Dicha legislación omite abordar adecuadamente los desafíos éticos y de derechos humanos inherentes al uso de la IA en el control migratorio. Al establecer distinciones legales que pueden ser explotadas para el monitoreo desproporcionado de individuos basándose en criterios discriminatorios, este hecho corre el riesgo de profundizar las desigualdades, perpetuar injusticias y sesgos contra aquellos ya en desventaja. La Ley de Inteligencia Artificial busca vetar prácticas de IA “inadmisibles” y define una estructura para la IA de “alto riesgo”, imponiendo normativas técnicas, de vigilancia y de responsabilidad cuando estos sistemas se desplieguen o comercialicen dentro del mercado europeo.

Lo que no tocan

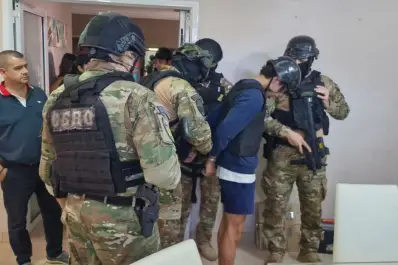

Pero por un lado, las restricciones impuestas a ciertos usos de la IA omiten específicamente el escenario migratorio. Mientras la legislación sí prohíbe ciertos usos dañinos de la IA, se ha rehusado a eliminar sistemas perjudiciales como aquellos que promueven la discriminación en la evaluación de riesgos migratorios y el análisis predictivo empleados para agilizar deportaciones. De igual forma, las prohibiciones contra el reconocimiento de emociones no se aplican en este ámbito, dejando fuera casos donde se han utilizado detectores de mentiras basados en IA en puntos fronterizos.

Además, la catalogación de sistemas de “alto riesgo” falla en capturar la amplia gama de tecnologías de IA empleadas en la gestión migratoria, lo que resulta en que dichas herramientas evadan las regulaciones establecidas en el reglamento.

Esto incluye sistemas excluidos de la lista como los de identificación biométrica en espacios de acceso público con fines de aplicación de la ley y herramientas predictivas usadas para prevenir y limitar la migración.

La ley omite el impacto extraterritorial de la exportación de tecnologías de vigilancia nocivas desarrolladas en la UE. A pesar de las evidencias de violaciones a los derechos humanos facilitadas por estas tecnologías en terceros países, no se prohíbe la exportación de sistemas vetados en Europa a otras regiones.

Esto sucede porque los países de la UE, las fuerzas del orden y los grupos que apoyan a la industria de la seguridad han presionado para que esto sea así. Estas agencias pueden usar la IA de maneras que otras no pueden, lo que incluye no tener que contarle al público cómo usan estos sistemas.

Imagínate que las autoridades tienen una herramienta especial de IA que pueden usar de manera secreta, sin necesidad de explicar cómo funciona ni dónde se utiliza. Esto significa que ni tú, ni yo, ni los periodistas, ni nadie fuera de esas agencias sabrá cuándo o cómo se están usando estas herramientas de IA. Esto es preocupante porque puede llevar a que se use la tecnología de una manera que no es justa o que invade la privacidad de las personas. Además, hay una regla en esta ley que les da a los países una especie de “salida fácil” para no seguir las normas en casos que consideren de “seguridad nacional”.

Alejandro Urueña - Etica e Inteligencia Artificial (IA) - Founder & CEO Clever Hans

Arquitectura y Soluciones en Inteligencia Artificial. Federico Augusto Lix Klett - 1er

Co-Fundador en Clever Hans Al y Fundador Clever Ads | Automatización inteligente,

lA, transformación empresarial | FALK Consultores